Cos’è la Metaverse Art?

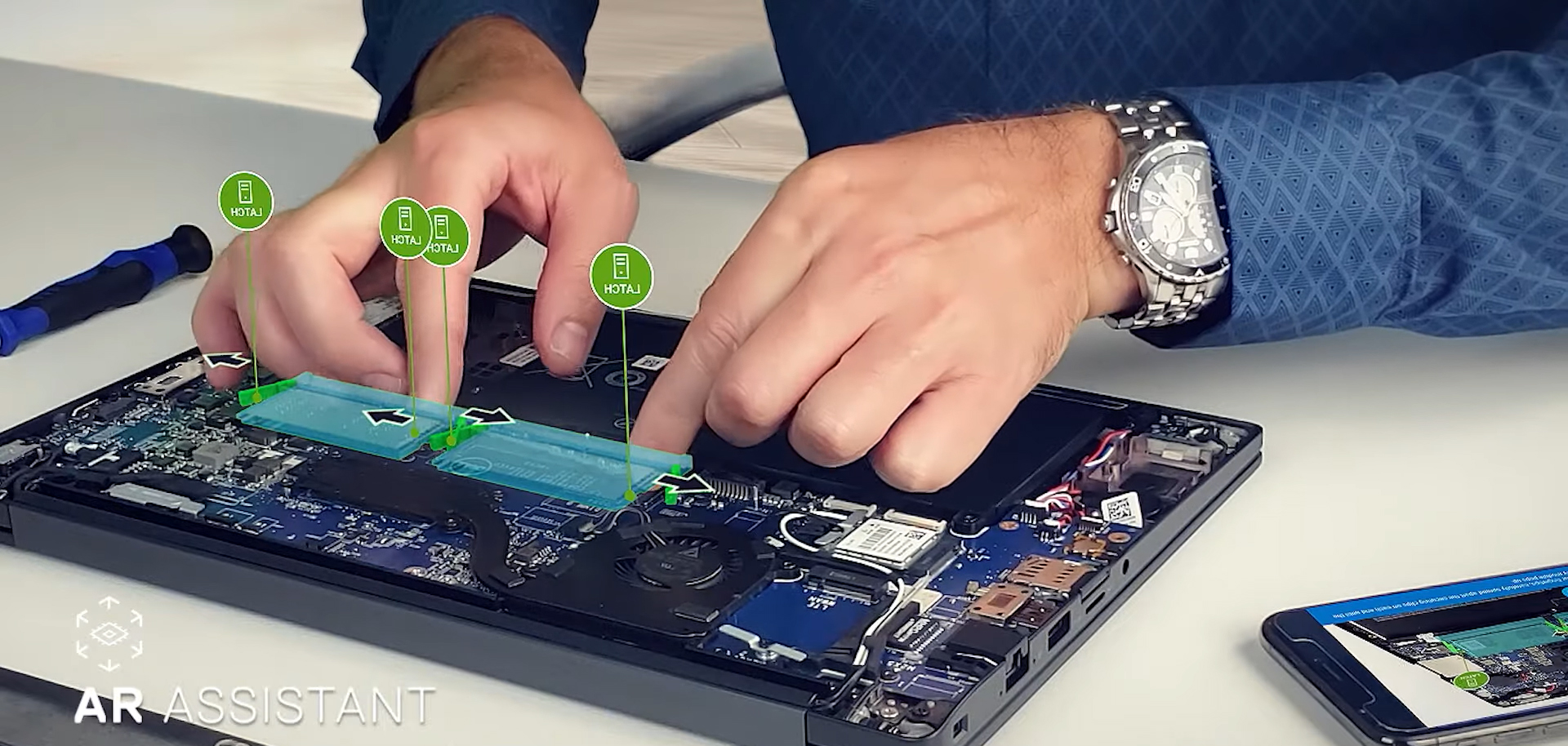

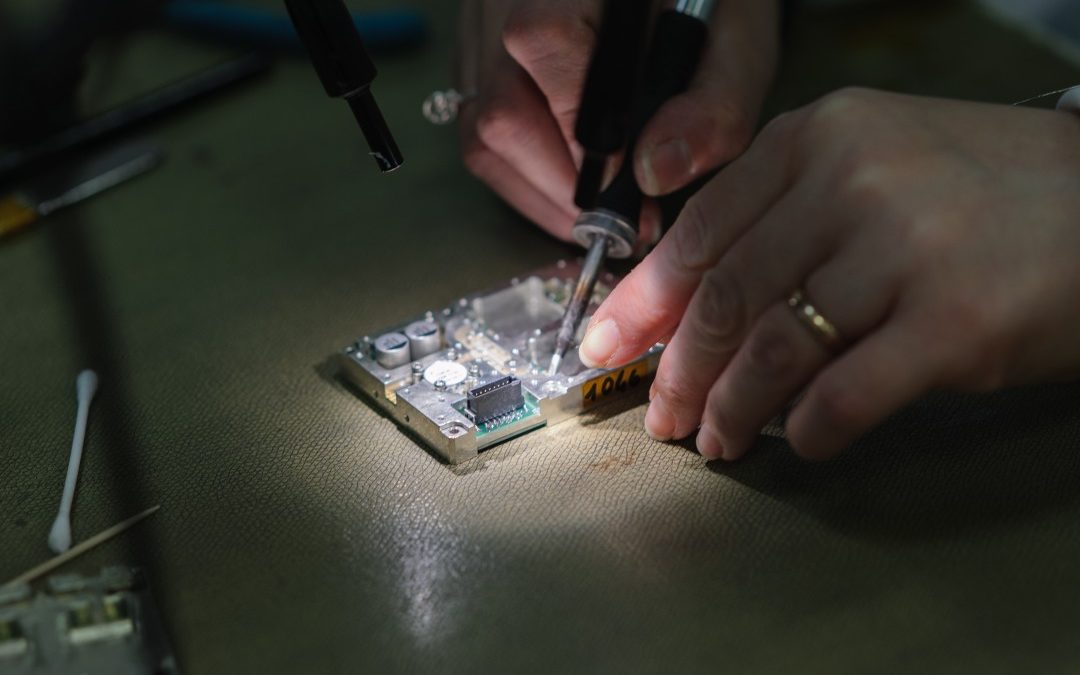

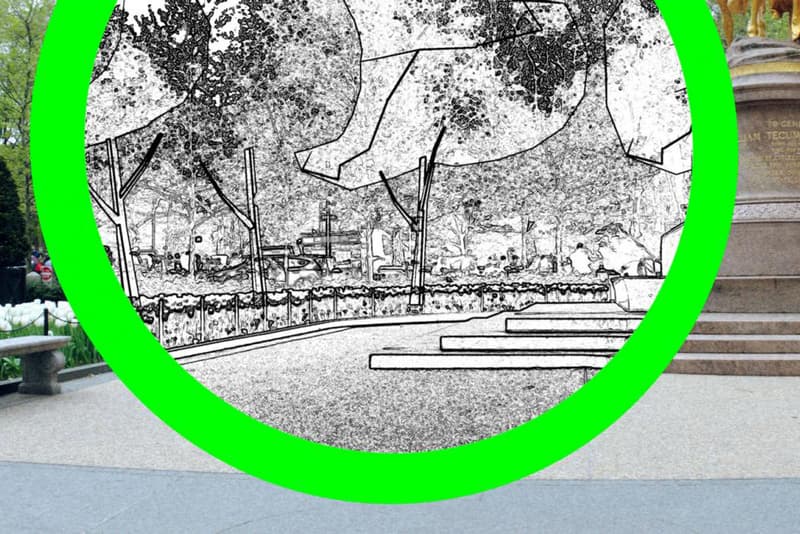

La Metaverse art è una forma di arte digitale che esiste all’interno di ambienti di realtà virtuale (VR) e realtà aumentata (AR). È un’esperienza immersiva che permette allo spettatore di entrare e interagire con una mostra o una galleria d’arte virtuale. A differenza dell’arte tradizionale, la Metaverse art non è limitata allo spazio fisico e gli artisti hanno la libertà di creare senza vincoli di dimensione, forma o materiale.

Le origini

La Metaverse art affonda le sue radici agli albori di Internet, con lo sviluppo di mondi virtuali come Second Life, una delle prime piattaforme che ha permesso agli utenti di creare e condividere le proprie creazioni digitali in uno spazio virtuale. Con l’avanzare della tecnologia, anche il mondo del della Metaverse Art se si è evoluto: nuove piattaforme come Decentraland e Cryptovoxels sono diventate destinazioni popolari per artisti e collezionisti.

Artisti e collezionisti

La Metaverse Art offre una serie di vantaggi sia per gli artisti che per i collezionisti. Per gli artisti, fornisce un nuovo mezzo di espressione creativa che non è limitato dallo spazio fisico o da vincoli materiali. Inoltre, consente agli artisti di raggiungere un pubblico globale, poiché le mostre virtuali sono accessibili da qualsiasi parte del mondo. Per i collezionisti, la Metaverse Art offre un nuovo modo di sperimentare e interagire con l’arte, con l’ulteriore vantaggio di poter vedere e collezionare rare opere d’arte digitale che possono rivalutarsi nel tempo.

Uno degli sviluppi più significativi nel mondo della Metaverse Art è stata l’ascesa dei token non fungibili (NFT). Gli NFT sono beni digitali unici memorizzati su una blockchain e possono rappresentare qualsiasi cosa, da opere d’arte a musica a immobili virtuali. Gli NFT sono diventati sempre più popolari nel mondo dell’arte, con alcune opere d’arte digitali vendute all’asta per milioni di dollari.

Il futuro

Con l’avanzare della tecnologia, le possibilità della Metaverse Art sono virtualmente illimitate. In futuro potremo assistere a esperienze virtuali ancora più coinvolgenti, con l’integrazione di tecnologie come il feedback aptico e la simulazione degli odori. Inoltre, ci aspettiamo di vedere un numero maggiore di collaborazioni tra artisti e tecnologi, che lavoreranno insieme per spingere i confini di ciò che è possibile nel Metaverso.

L’impatto della Metaverse Art va ben oltre il mondo dell’arte. Ha il potenziale per cambiare il modo in cui pensiamo alla creatività, all’innovazione e alla collaborazione. Ha anche il potenziale di democratizzare il mondo dell’arte, rendendolo più accessibile a un pubblico più vasto. Continuando a esplorare le possibilità della Metaverse Art, possiamo aspettarci di vederla giocare un ruolo sempre più importante nel plasmare il nostro panorama culturale.

Conclusione

In conclusione, la Metaverse Art è un campo eccitante e in rapida evoluzione che offre una nuova forma di espressione artistica non limitata dallo spazio fisico o da vincoli materiali. Offre agli artisti nuove opportunità di creare e condividere le loro opere e ai collezionisti nuovi modi di sperimentare e interagire con l’arte. Con l’avanzare della tecnologia, possiamo aspettarci di vedere sviluppi ancora più entusiasmanti nel mondo della Metaverse Art, con il potenziale di trasformare il nostro panorama culturale in modi che possiamo solo immaginare.

Mirko Compagno